Paradox soukromí moderních asistentů AI

Za těmito bezproblémovými interakcemi se však skrývá komplexní prostředí ochrany osobních údajů, kterému plně rozumí jen málo uživatelů. Samotná povaha konverzační umělé inteligence vytváří zásadní napětí: tyto systémy potřebují data – často osobní, někdy citlivá –, aby fungovaly efektivně, ale stejný sběr dat vytváří významné důsledky pro soukromí, které nelze ignorovat.

Toto napětí představuje to, co výzkumníci v oblasti soukromí nazývají „paradox funkčnosti a soukromí“. Asistenti umělé inteligence o vás potřebují vědět, aby mohli poskytovat personalizované, kontextově relevantní odpovědi. Vaše preference, historie, poloha a zvyky, to vše poskytuje užitečnější interakce. Ale každá shromážděná informace představuje potenciální ohrožení soukromí, které musí být pečlivě spravováno a chráněno.

Sázky nikdy nebyly vyšší. Vzhledem k tomu, že konverzační rozhraní přecházejí od jednoduchých příkazů („Nastav časovač na 10 minut“) ke komplexním, kontextovým interakcím („Připomeň mi, že mám na toto téma upozornit z e-mailu z minulého týdne, až se zítra setkám se Sarah“), dopady na soukromí exponenciálně rostou. Tyto systémy již nezpracovávají pouze izolované požadavky, ale vytvářejí komplexní uživatelské modely, které pokrývají více oblastí našeho života.

Pro vývojáře, firmy a uživatele, kteří se v tomto prostředí pohybují, je pochopení jedinečných výzev v oblasti ochrany soukromí konverzační umělé inteligence prvním krokem k odpovědné implementaci a používání. Pojďme prozkoumat tento složitý terén a nově vznikající strategie, jak vyvážit výkonnou funkčnost a robustní ochranu soukromí.

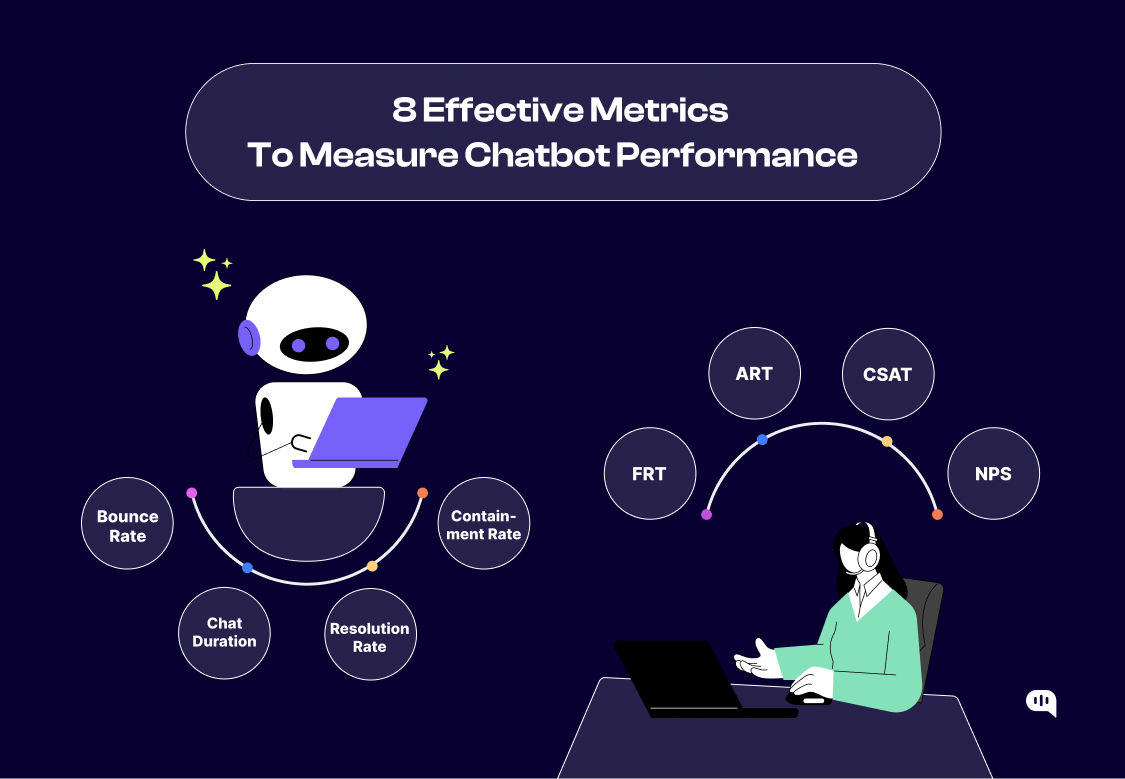

Pochopte, co se skutečně děje s vašimi hlasovými daty

Proces obvykle začíná sběrem dat. Hlasové systémy převádějí zvuk na digitální signály, zatímco textová rozhraní zachycují zadané vstupy. Tato nezpracovaná data pak procházejí několika fázemi zpracování, které mohou zahrnovat:

Převod řeči na text pro hlasové vstupy

Zpracování přirozeného jazyka k určení záměru

Kontextová analýza, která může zahrnovat předchozí interakce

Generování odezvy na základě trénovaných modelů AI

Dodatečné zpracování pro personalizaci

Ukládání interakcí pro vylepšení systému

Každá fáze představuje odlišné aspekty ochrany soukromí. Kde například probíhá převod řeči na text – na vašem zařízení nebo na vzdálených serverech? Jsou nahrávky vašeho hlasu uloženy, a pokud ano, na jak dlouho? Kdo může mít přístup k těmto nahrávkám? Poslouchá systém nepřetržitě, nebo až po probuzení?

Hlavní poskytovatelé mají k těmto otázkám různé přístupy. Některé zpracovávají všechna data v cloudu, zatímco jiné provádějí počáteční zpracování na zařízení, aby omezily přenos dat. Zásady úložiště se velmi liší, od neomezeného uchovávání až po automatické mazání po určených obdobích. Kontroly přístupu sahají od přísného omezení až po autorizované použití lidskými kontrolory pro zlepšení kvality.

Skutečnost je taková, že i když mají společnosti přísné zásady ochrany osobních údajů, inherentní složitost těchto systémů ztěžuje uživatelům udržet jasný přehled o tom, jak přesně jsou jejich data používána. Nedávná odhalení o lidských recenzentech, kteří poslouchají nahrávky hlasových asistentů, překvapila mnoho uživatelů, kteří předpokládali, že jejich interakce zůstaly zcela soukromé nebo byly zpracovány pouze automatizovanými systémy.

K této složitosti přispívá distribuovaná povaha moderních asistentů AI. Když se svého chytrého reproduktoru zeptáte na restaurace v okolí, může tento dotaz interagovat s více systémy – základní umělou inteligencí asistenta, mapovými službami, databázemi restaurací, platformami pro recenze – každý se svými vlastními datovými postupy a dopady na soukromí.

Aby uživatelé mohli činit informovaná rozhodnutí, je nezbytná větší transparentnost těchto procesů. Někteří poskytovatelé v tomto směru udělali pokrok a nabídli jasnější vysvětlení datových postupů, podrobnější kontroly ochrany osobních údajů a možnosti kontroly a mazání historických dat. Stále však přetrvávají značné mezery v pomoci uživatelům skutečně porozumět důsledkům jejich každodenních interakcí s umělou inteligencí na soukromí.

Regulační krajina: Vyvíjející se, ale nekonzistentní

Obecné nařízení Evropské unie o ochraně osobních údajů (GDPR) představuje jeden z nejkomplexnějších rámců, které stanoví zásady, které významně ovlivňují konverzační umělou inteligenci:

Požadavek na konkrétní informovaný souhlas před zpracováním osobních údajů

Principy minimalizace dat, které omezují sběr na to, co je nezbytné

Účelové omezení, které omezuje použití dat nad rámec uvedených záměrů

Právo na přístup k osobním údajům, které společnosti uchovávají

Právo být zapomenut (výmaz údajů na vyžádání)

Požadavky na přenositelnost dat mezi službami

Tyto požadavky představují zvláštní výzvy pro konverzační umělou inteligenci, která se často opírá o široký sběr dat a může se potýkat s jasným omezením účelu, když jsou systémy navrženy tak, aby zpracovávaly různé a nepředvídatelné požadavky.

Ve Spojených státech zůstává regulace ochrany osobních údajů roztříštěnější, přičemž kalifornský zákon o ochraně soukromí spotřebitelů (CCPA) a jeho nástupce zákon o ochraně osobních údajů v Kalifornii (CPRA) zavádějí nejsilnější ochranu na státní úrovni. Tato nařízení poskytují obyvatelům Kalifornie práva podobná těm podle GDPR, včetně přístupu k osobním údajům a práva na vymazání údajů. Ostatní státy následovaly s vlastní legislativou a vytvořily mozaiku požadavků po celé zemi.

Specializované předpisy přidávají další složitost. V kontextu zdravotnictví ukládají předpisy HIPAA v USA přísné požadavky na zacházení s lékařskými informacemi. Pro služby zaměřené na děti zákon COPPA zavádí další ochranu, která omezuje shromažďování a používání dat.

Globální povaha většiny konverzačních služeb umělé inteligence znamená, že společnosti musí obvykle navrhovat ty nejpřísnější platné předpisy a zároveň řídit dodržování předpisů v různých jurisdikcích. Toto složité prostředí vytváří výzvy jak pro zavedené společnosti, které se pohybují různými požadavky, tak pro začínající podniky s omezenými právními zdroji.

Pro uživatele znamená nekonzistentní regulační prostředí, že ochrana soukromí se může výrazně lišit v závislosti na tom, kde žijí. Lidé v regionech se silnými zákony na ochranu dat mají obecně více práv ohledně svých konverzačních dat AI, zatímco ostatní mohou mít méně právní ochrany.

Regulační prostředí se nadále vyvíjí a v mnoha regionech se připravují nové právní předpisy, které se konkrétně zabývají řízením umělé inteligence. Tyto vznikající rámce mohou poskytnout přizpůsobenější přístupy k jedinečným výzvám konverzační umělé inteligence v oblasti soukromí a potenciálně vytvořit jasnější standardy pro souhlas, transparentnost a správu dat v těchto stále důležitějších systémech.

Technické výzvy konverzační umělé inteligence chránící soukromí

Na průsečíku konverzační umělé inteligence a soukromí stojí několik klíčových technických výzev:

Zpracování na zařízení vs. Cloud Computing

Přesunutí zpracování z cloudu do zařízení (edge computing) může výrazně zlepšit soukromí tím, že citlivá data uchová místní. Tento přístup však naráží na podstatná omezení:

Mobilní a domácí zařízení mají ve srovnání s cloudovou infrastrukturou omezené výpočetní zdroje

Větší modely AI se nemusí hodit na spotřebitelská zařízení

Modely na zařízení mohou poskytovat méně kvalitní odpovědi bez přístupu k centralizovanému učení

Časté aktualizace modelu mohou spotřebovat značnou šířku pásma a úložiště

Navzdory těmto výzvám pokrok v kompresi modelů a specializovaný hardware AI činí zpracování na zařízení stále životaschopnějším. Některé systémy nyní využívají hybridní přístupy, provádějí počáteční zpracování lokálně a do cloudu odesílají pouze nezbytná data.

Strojové učení pro zachování soukromí

Tradiční přístupy strojového učení se soustředily na centralizovaný sběr dat, ale objevují se alternativy zaměřené na soukromí:

Federované učení umožňuje trénovat modely napříč mnoha zařízeními a zároveň uchovávat osobní data na místní úrovni. S centrálními servery jsou sdíleny pouze aktualizace modelu (nikoli uživatelská data), což chrání soukromí jednotlivců a zároveň umožňuje vylepšování systému.

Diferenciální soukromí zavádí vypočítaný šum do datových sad nebo dotazů, aby se zabránilo identifikaci jednotlivců při zachování statistické platnosti pro školení a analýzu.

Zabezpečený výpočet prováděný více stranami umožňuje analýzu napříč více zdroji dat, aniž by kterákoli strana musela odhalovat svá nezpracovaná data ostatním.

Tyto techniky jsou slibné, ale přicházejí s kompromisy ve výpočetní efektivitě, složitosti implementace a někdy nižší přesnosti ve srovnání s tradičními přístupy.

Strategie minimalizace dat

Návrh zaměřený na soukromí vyžaduje shromažďování pouze dat nezbytných pro zamýšlenou funkčnost, ale definice „nezbytného“ pro flexibilní konverzační systémy představuje potíže:

Jak mohou systémy předem určit, jaký kontext může být potřebný pro budoucí interakce?

Jaké základní informace jsou nutné k poskytování personalizovaných, ale soukromí respektujících zkušeností?

Jak mohou systémy vyvážit okamžité potřeby funkčnosti a potenciální budoucí užitečnost?

Některé přístupy se zaměřují na časově omezené uchovávání dat a ukládají historii interakcí pouze po definovaná období relevantní pro očekávané vzorce používání. Jiné kladou důraz na uživatelskou kontrolu a umožňují jednotlivcům určit, která historická data by měla být zachována nebo zapomenuta.

Omezení anonymizace

Tradiční anonymizační techniky se často ukazují jako nedostatečné pro konverzační data, která obsahují bohaté kontextové informace, které mohou usnadnit opětovnou identifikaci:

Řečové vzorce a výběr slov mohou být vysoce identifikující

Otázky týkající se osobních okolností mohou odhalit identifikovatelné podrobnosti, i když jsou odstraněny přímé identifikační údaje

Kumulativní účinek vícenásobných interakcí může vytvořit identifikovatelné profily i ze zdánlivě anonymních individuálních výměn

Výzkum pokročilých technik anonymizace speciálně navržených pro konverzační obsah pokračuje, ale dokonalá anonymizace při zachování užitečnosti zůstává nepolapitelným cílem.

Tyto technické problémy zdůrazňují, proč konverzační umělá inteligence chránící soukromí vyžaduje zásadně nové přístupy, spíše než pouhé použití tradičních technik ochrany soukromí na stávající architektury umělé inteligence. Pokrok vyžaduje hlubokou spolupráci mezi výzkumníky v oblasti umělé inteligence, odborníky na ochranu soukromí a systémovými architekty, aby bylo možné vyvinout přístupy, které respektují soukromí již od návrhu, nikoli jako dodatečný nápad.

Transparentnost a souhlas: Přehodnocení uživatelské kontroly

Transparentnost a souhlas pro konverzační rozhraní komplikuje několik faktorů:

Neformální model interakce založený na řeči se nehodí k podrobnému vysvětlení ochrany soukromí

Uživatelé často nerozlišují mezi různými funkčními doménami, které mohou mít různé dopady na soukromí

Pokračující vztah s konverzační umělou inteligencí vytváří několik potenciálních momentů souhlasu

Kontextové systémy mohou shromažďovat informace, které uživatelé výslovně nezamýšleli sdílet

Integrace třetích stran vytvářejí složité datové toky, které je obtížné jasně komunikovat

Progresivní společnosti zkoumají nové přístupy, které lépe vyhovují těmto výzvám:

Vrstvené zveřejnění

Spíše než zahlcení uživatelů komplexními informacemi o ochraně soukromí najednou poskytuje vrstvené zveřejňování informace ve stravitelných segmentech v relevantních okamžicích:

Počáteční nastavení zahrnuje základní volby ochrany soukromí

Při použití nových funkcí jsou vysvětleny dopady na soukromí specifické pro jednotlivé funkce

Pravidelné kontroly ochrany soukromí kontrolují shromažďování a používání dat

Informace o soukromí jsou dostupné na vyžádání prostřednictvím specifických hlasových příkazů

Tento přístup uznává, že porozumění soukromí se v průběhu času vyvíjí spíše opakovanými interakcemi než z jediného odhalení.

Kontextový souhlas

Kontextový souhlas, který přesahuje binární modely přihlášení/odhlášení, vyžaduje povolení ve smysluplných rozhodovacích bodech na cestě uživatele:

Kdy by byl shromažďován nový typ osobních údajů

Před povolením funkcí s významnými dopady na soukromí

Při přechodu z místního na cloudové zpracování

Před sdílením dat se službami třetích stran

Při změně způsobu použití dříve shromážděných dat

Podstatné je, že kontextový souhlas poskytuje dostatek informací pro informovaná rozhodnutí, aniž by uživatele zahltil, a vysvětluje výhody a dopady každé volby na soukromí.

Interaktivní ovládací prvky ochrany osobních údajů

Rozhraní Voice-first vyžadují hlasově dostupné ovládací prvky soukromí. Přední systémy vyvíjejí rozhraní přirozeného jazyka pro správu soukromí:

"Jaké informace o mně uchováváte?"

"Smazat moji nákupní historii z minulého týdne"

"Zastavit ukládání mých hlasových nahrávek"

"Kdo má přístup k mým otázkám o zdravotních tématech?"

Tyto konverzační ovládací prvky soukromí dělají ochranu přístupnější než skryté nabídky nastavení, ačkoli představují své vlastní konstrukční problémy při potvrzování identity a záměru uživatele.

Osobní údaje o ochraně osobních údajů a učení o preferencích

Některé systémy zkoumají soukromí „osoby“ nebo profily, které sdružují související možnosti ochrany soukromí pro zjednodušení rozhodování. Jiní používají strojové učení, aby porozuměli individuálním preferencím ochrany soukromí v průběhu času a navrhli vhodná nastavení na základě minulých voleb, přičemž si stále zachovávají explicitní kontrolu.

Pro firmy a vývojáře vyžaduje navrhování účinných mechanismů transparentnosti a souhlasu uznání, že uživatelé mají různé preference ochrany soukromí a úrovně gramotnosti. Nejúspěšnější přístupy se přizpůsobují této rozmanitosti tím, že poskytují více cest k pochopení a ovládání spíše než univerzální řešení.

S tím, jak se konverzační umělá inteligence hlouběji integruje do každodenního života, zůstává vytváření rozhraní, která efektivně komunikují důsledky pro ochranu soukromí, aniž by narušovala přirozenou interakci, trvalou návrhářskou výzvou – ale zásadní pro budování důvěryhodných systémů.

Vyzkoušejte AI na VAŠEM webu za 60 sekund

Podívejte se, jak naše AI okamžitě analyzuje váš web a vytvoří personalizovaného chatbota - bez registrace. Stačí zadat URL adresu a sledovat, jak to funguje!

Zvláštní ohledy na zranitelné skupiny obyvatel

Děti a soukromí

Děti představují populaci, která vzbuzuje zvláštní obavy, protože nemusí chápat důsledky pro soukromí, ale stále častěji interagují s konverzačními rozhraními:

Mnoho dětí postrádá vývojovou schopnost činit informovaná rozhodnutí o ochraně soukromí.

Děti mohou v konverzaci sdílet informace volněji, aniž by chápaly potenciální důsledky.

Mladí uživatelé nemusí rozlišovat mezi rozhovorem s umělou inteligencí a důvěryhodným lidským důvěrníkem.

Data shromážděná během dětství by mohla jednotlivce sledovat po celá desetiletí.

Regulační rámce, jako je COPPA v USA a specifická ustanovení GDPR pro děti, stanoví základní ochranu, ale implementační problémy přetrvávají. Technologie rozpoznávání hlasu může mít potíže se spolehlivou identifikací dětských uživatelů, což komplikuje opatření na ochranu soukromí odpovídající věku. Systémy určené primárně pro dospělé nemusí dostatečně vysvětlovat koncepty soukromí v jazyce srozumitelném pro děti.

Vývojáři, kteří vytvářejí konverzační umělou inteligenci nebo funkce zaměřené na děti, musí zvážit specializované přístupy, včetně:

Výchozího nastavení s vysokým soukromím s rodičovskou kontrolou pro úpravy

Věkově přiměřeného vysvětlení shromažďování dat s využitím konkrétních příkladů

Omezené doby uchovávání dat pro dětské uživatele

Omezeného používání dat, které zakazuje profilování nebo behaviorální cílení

Jasných indikátorů, kdy budou informace sdíleny s rodiči

Starší dospělí a aspekty přístupnosti

Starší dospělí a osoby se zdravotním postižením mohou mít značné výhody z konverzačních rozhraní, která často poskytují přístupnější modely interakce než tradiční počítačová rozhraní. Mohou však také čelit specifickým problémům s ochranou soukromí:

Omezená znalost technologických konceptů může ovlivnit pochopení soukromí

Kognitivní poruchy mohou ovlivnit schopnost složitých rozhodnutí o ochraně soukromí

Závislost na asistenčních technologiích může snížit praktickou schopnost odmítnout podmínky ochrany soukromí

Použití související se zdravím může zahrnovat obzvláště citlivá data

Sdílená zařízení v pečovatelských zařízeních vytvářejí složité scénáře souhlasu

Zodpovědný design pro tyto populace vyžaduje promyšlené úpravy bez kompromisů v oblasti svobodné vůle. Mezi přístupy patří:

Multimodální vysvětlení soukromí, která prezentují informace v různých formátech

Zjednodušená rozhodnutí o soukromí zaměřená na praktické dopady spíše než na technické detaily

V případě potřeby určení důvěryhodných zástupců pro rozhodnutí o soukromí

Zvýšené zabezpečení funkcí souvisejících se zdravím a péčí

Jasné oddělení obecné pomoci a lékařských rad

Digitální gramotnost a propast v oblasti soukromí

Napříč věkovými skupinami vytvářejí různé úrovně digitální a soukromí gramotnosti to, co vědci nazývají „propast v oblasti soukromí“ – ti s větším porozuměním mohou lépe chránit své informace, zatímco jiní zůstávají zranitelnější. Konverzační rozhraní, i když jsou potenciálně intuitivnější než tradiční výpočetní technika, stále s sebou nesou komplexní důsledky pro soukromí, které nemusí být zřejmé všem uživatelům.

Překlenutí této propasti vyžaduje přístupy, které zpřístupňují soukromí bez nutnosti technických znalostí:

Vysvětlení soukromí, která se zaměřují na konkrétní výsledky spíše než na technické mechanismy

Příklady ilustrující potenciální rizika pro soukromí v relevantních scénářích

Postupné zveřejňování, které zavádí koncepty, jakmile se stanou relevantními

Alternativy k textově náročným informacím o soukromí, včetně vizuálních a zvukových formátů

V konečném důsledku vyžaduje vytvoření skutečně inkluzivní konverzační umělé inteligence uznání, že potřeby a chápání soukromí se v jednotlivých populacích výrazně liší. Univerzální přístupy nevyhnutelně zanechávají zranitelné uživatele s nedostatečnou ochranou nebo je vylučují z prospěšných technologií. Nejetičtější implementace tyto rozdíly uznávají a poskytují vhodné úpravy a zároveň respektují individuální autonomii.

Obchodní úvahy: Vyvažování inovací a odpovědnosti

Obchodní případ pro design zaměřený na soukromí

I když se na první pohled může zdát, že ochrana soukromí omezuje obchodní příležitosti, perspektivní společnosti stále více uznávají obchodní hodnotu přísných zásad ochrany soukromí:

Důvěra jako konkurenční výhoda – S rostoucím povědomím o ochraně osobních údajů se důvěryhodné datové postupy stávají významným rozdílem. Výzkum neustále ukazuje, že spotřebitelé preferují služby, o kterých se domnívají, že ochrání jejich osobní údaje.

Účinnost dodržování předpisů – Začlenění soukromí do konverzační umělé inteligence od začátku snižuje nákladné dodatečné vybavení, protože předpisy se vyvíjejí. Tento přístup „privacy by design“ představuje významné dlouhodobé úspory ve srovnání s řešením ochrany soukromí jako dodatečného nápadu.

Zmírnění rizik – Porušení dat a skandály týkající se soukromí s sebou nesou značné náklady, od regulačních sankcí až po poškození pověsti. Návrh zaměřený na soukromí snižuje tato rizika prostřednictvím minimalizace dat a vhodných bezpečnostních opatření.

Přístup na trh – Přísné zásady ochrany osobních údajů umožňují provoz v regionech s přísnými předpisy a rozšiřují potenciální trhy bez nutnosti více verzí produktů.

Tyto faktory vytvářejí přesvědčivé obchodní pobídky pro investice do soukromí nad rámec pouhého souladu, zejména pro konverzační AI, kde důvěra přímo ovlivňuje ochotu uživatelů zapojit se do technologie.

Strategické přístupy ke sběru dat

Společnosti musí uvážlivě rozhodovat o tom, jaká data jejich konverzační systémy shromažďují a jak se používají:

Funkční minimalismus – Shromažďování pouze dat přímo požadovaných pro požadovanou funkcionalitu s jasnými hranicemi mezi nezbytným a volitelným sběrem dat.

Účelová specifičnost – Definování úzkých, explicitních účelů pro použití dat spíše než široký, otevřený sběr, který by mohl sloužit budoucím nespecifikovaným potřebám.

Rozlišení transparentnosti – Jasné rozlišení mezi daty použitými pro okamžitou funkčnost a vylepšením systému, což uživatelům poskytuje samostatnou kontrolu nad těmito různými způsoby použití.

Úrovně ochrany osobních údajů – Nabízí možnosti služeb s různými kompromisy mezi soukromím a funkčností, což uživatelům umožňuje vybrat si preferovaný zůstatek.

Tyto přístupy pomáhají společnostem vyhnout se myšlence „shromáždit všechno možné“, která vytváří jak rizika pro soukromí, tak potenciální regulační riziko.

Vyvážení integrace první a třetí strany

Konverzační platformy často slouží jako brány do širších ekosystémů služeb, což vyvolává otázky týkající se sdílení a integrace dat:

Jak by měl být spravován souhlas uživatele, když konverzace zahrnují více služeb?

Kdo nese odpovědnost za ochranu soukromí napříč integrovanými zkušenostmi?

Jak lze konzistentně udržovat očekávání v oblasti ochrany soukromí v celém ekosystému?

Jaké informace o ochraně soukromí by měli sdílet integrační partneři?

Přední společnosti řeší tyto výzvy prostřednictvím jasných požadavků partnerů, standardizovaných rozhraní pro ochranu soukromí a transparentního zveřejňování datových toků mezi službami. Některé implementují „ochranné štítky s nutričními hodnotami“, které rychle sdělují základní informace o ochraně osobních údajů předtím, než se uživatelé zapojí do služeb třetích stran prostřednictvím jejich konverzačních platforem.

Vytváření udržitelné správy dat

Účinná ochrana soukromí vyžaduje robustní struktury řízení, které vyvažují potřeby inovací a odpovědností za soukromí:

Mezifunkční týmy na ochranu soukromí, které zahrnují produktová, inženýrská, právní a etická hlediska

Posouzení dopadu na soukromí prováděná na počátku vývoje produktu

Pravidelné audity ochrany osobních údajů k ověření souladu s uvedenými zásadami

Jasné struktury odpovědnosti definující odpovědnost za ochranu soukromí v celé organizaci

Etické komise řeší nové otázky ochrany soukromí, které vyvstávají v konverzačních kontextech

Tyto mechanismy řízení pomáhají zajistit, aby byly úvahy o ochraně soukromí integrovány do celého procesu vývoje, spíše než aby se řešily až v závěrečných fázích revize, kdy se změny stanou nákladnými.

Pro podniky, které investují do konverzační umělé inteligence, by soukromí nemělo být vnímáno jako zátěž související s dodržováním předpisů, ale jako základní prvek udržitelné inovace. Společnosti, které zavádějí důvěryhodné postupy ochrany osobních údajů, vytvářejí podmínky pro širší přijetí a přijetí jejich konverzačních technologií, což v konečném důsledku umožňuje hodnotnější uživatelské vztahy.

Vzdělávání a zmocnění uživatelů: Nad rámec zásad ochrany osobních údajů

Omezení tradiční komunikace o soukromí

Standardní přístupy ke komunikaci na ochranu soukromí jsou pro konverzační rozhraní obzvláště nedostačující:

Zásady ochrany osobních údajů jsou zřídka čteny a často psány složitým právním jazykem

Tradiční rozhraní pro správu soukromí se špatně přenášejí do hlasových interakcí

Jednorázový souhlas neřeší pokračující, vyvíjející se povahu konverzačních vztahů

Technická vysvětlení ochrany soukromí často nedokážou sdělit praktické důsledky pro uživatele

Tato omezení vytvářejí situaci, kdy lze dosáhnout formálního souladu (uživatelé „souhlasili“ s podmínkami) bez smysluplného informovaného souhlasu. Uživatelé nemusí rozumět tomu, jaká data jsou shromažďována, jak jsou používána nebo jakou kontrolu nad svými informacemi mají.

Vytváření smysluplné gramotnosti v oblasti soukromí

Efektivnější přístupy se zaměřují na budování skutečného porozumění soukromí prostřednictvím:

Just-in-time vzdělávání, které poskytuje relevantní informace o ochraně soukromí v klíčových okamžicích, nikoli najednou

Vysvětlení v jednoduchém jazyce, které se zaměřují spíše na praktické výsledky než na technické mechanismy

Konkrétní příklady ilustrující, jak lze data používat, a potenciální dopady na soukromí

Interaktivní ukázky, díky nimž jsou koncepty ochrany soukromí spíše hmatatelné než abstraktní

Kontextové připomenutí toho, jaká data se shromažďují během různých typů interakcí

Tyto přístupy uznávají, že gramotnost v oblasti ochrany soukromí se rozvíjí postupně opakovaným vystavením a praktickými zkušenostmi, nikoli prostřednictvím jednorázových ukládání informací.

Navrhování pro agenturu a kontrolu

Kromě vzdělávání potřebují uživatelé skutečnou kontrolu nad svými informacemi. Mezi účinné přístupy patří:

Podrobná oprávnění, která uživatelům umožňují schvalovat konkrétní použití namísto souhlasu vše nebo nic

Panely ochrany osobních údajů poskytující jasnou vizualizaci toho, jaká data byla shromážděna

Jednoduché možnosti mazání pro odstranění historických informací

Statistiky využití ukazující, jak osobní údaje ovlivňují chování systému

Zkratky ochrany osobních údajů pro rychlou úpravu běžných nastavení

Pravidelné kontroly ochrany soukromí vyžadující kontrolu aktuálního nastavení a sběru dat

Důležité je, že tyto ovládací prvky musí být snadno přístupné prostřednictvím samotného konverzačního rozhraní, nikoli pohřbené v samostatných webových stránkách nebo aplikacích, které vytvářejí třenice pro uživatele, kteří používají hlas jako první.

Komunitní normy a sociální normy

Jak se konverzační umělá inteligence stává všudypřítomnější, komunitní normy a sociální normy hrají stále důležitější roli při utváření očekávání v oblasti soukromí. Společnosti mohou přispět ke zdravému vývoji norem tím, že:

Usnadnění vzdělávání mezi uživateli v oblasti ochrany soukromí prostřednictvím komunitních fór a sdílení znalostí

Zdůraznění osvědčených postupů ochrany soukromí a rozpoznání uživatelů, kteří je zaměstnávají

Vytvoření transparentnosti ohledně souhrnných možností ochrany soukromí, které uživatelům pomůže pochopit normy komunity

Zapojení uživatelů do vývoje funkcí ochrany osobních údajů prostřednictvím zpětné vazby a společného návrhu

Tyto přístupy uznávají, že soukromí není pouze individuálním zájmem, ale sociálním konstruktem, který se vyvíjí prostřednictvím kolektivního porozumění a praxe.

Aby konverzační umělá inteligence dosáhla svého plného potenciálu při respektování individuálních práv, musí se uživatelé stát spíše informovanými účastníky než pasivními subjekty sběru dat. To vyžaduje trvalé investice do vzdělávání a posílení postavení spíše než minimální dodržování požadavků na zveřejňování. Společnosti, které v této oblasti vedou, posilují uživatelské vztahy a zároveň přispívají ke zdravějšímu celkovému ekosystému pro konverzační technologie.

Vznikající řešení a osvědčené postupy

Technologie zvyšující soukromí pro konverzační umělou inteligenci

Mezi technické inovace, které se konkrétně zaměřují na soukromí v konverzačních kontextech, patří:

Lokální zpracovatelské enklávy, které provádějí citlivé výpočty na zařízení v zabezpečeném prostředí izolovaném od ostatních aplikací

Homomorfní šifrovací techniky umožňující zpracování zašifrovaných dat bez dešifrování, umožňující analýzu zachování soukromí

Syntetická trénovací data generovaná pro zachování statistických vlastností skutečných konverzací bez odhalení skutečných uživatelských interakcí

Transkripce chránící soukromí, která lokálně převádí řeč na text před odesláním minimalizovaných textových dat ke zpracování

Implementace federovaného učení speciálně optimalizované pro distribuovanou povahu konverzačních zařízení

Tyto technologie jsou v různých fázích vyspělosti, přičemž některé se již objevují v komerčních produktech, zatímco jiné zůstávají primárně ve fázi výzkumu.

Průmyslové standardy a rámce

Odvětví konverzační umělé inteligence vyvíjí sdílené standardy a rámce pro vytvoření konzistentních přístupů k ochraně soukromí:

Voice Privacy Alliance navrhla pro hlasové asistenty standardizované kontroly soukromí a formáty zveřejňování

IEEE má pracovní skupiny vyvíjející technické standardy pro ochranu soukromí v mluvených rozhraních

Open Voice Network vytváří standardy interoperability, které zahrnují požadavky na soukromí

Různá průmyslová sdružení zveřejnila osvědčené postupy ochrany soukromí specifické pro konverzační kontexty

Cílem těchto společných snah je stanovit základní očekávání v oblasti ochrany osobních údajů, která zjednoduší dodržování předpisů pro vývojáře a zároveň zajistí konzistentní uživatelské prostředí napříč platformami.

Návrhové vzory pro konverzační UX respektující soukromí

Návrháři uživatelského prostředí vyvíjejí specializované vzory pro zpracování soukromí v konverzačních rozhraních:

Progresivní zveřejňování ochrany osobních údajů, které zavádí informace do spravovatelných segmentů

Okolní indikátory soukromí využívající jemné zvukové nebo vizuální podněty k indikaci, kdy systémy poslouchají nebo zpracovávají

Choreografie souhlasu navrhující přirozené žádosti o povolení, které nenarušují tok konverzace

Výchozí nastavení pro zachování soukromí, které začíná minimálním shromažďováním dat a rozšiřuje se pouze s výslovným souhlasem uživatele

Zapomínání na mechanismy, které činí z vypršení platnosti a mazání dat nedílnou součást modelu interakce

Cílem těchto návrhových vzorů je učinit z hledisek ochrany soukromí nedílnou součást konverzačního prostředí spíše než samostatnou vrstvu požadavků na shodu.

Organizační osvědčené postupy

Organizace vedoucí v oblasti konverzační umělé inteligence respektující soukromí obvykle implementují několik klíčových postupů:

Zastánci ochrany soukromí zabudovaní do vývojových týmů, nejen do právních oddělení

Pravidelné hodnocení rizik ochrany soukromí během životního cyklu vývoje

Uživatelské testování zaměřené na soukromí, které explicitně hodnotí porozumění a kontrolu soukromí

Přehledy transparentnosti poskytující přehled o postupech při zpracování dat a žádostech o vládní informace

Externí audity ochrany soukromí ověřující, že skutečné postupy odpovídají stanoveným zásadám

Programy odměny za chyby v soukromí, které podporují identifikaci zranitelností soukromí

Tyto organizační přístupy zajišťují, že ohledy na ochranu soukromí zůstanou ústředním bodem vývoje produktu, spíše než aby se staly dodatečnými myšlenkami během právního přezkumu.

Vývojářům a společnostem pracujícím v tomto prostoru poskytují tato vznikající řešení cenný směr pro vytváření konverzační umělé inteligence, která respektuje soukromí a zároveň poskytuje přesvědčivé uživatelské zkušenosti. I když žádný jediný přístup neřeší všechny problémy s ochranou soukromí, promyšlená kombinace technických, designových a organizačních postupů může podstatně zlepšit výsledky ochrany soukromí.

Budoucnost soukromí v konverzační umělé inteligenci

From Centralized to Distributed Intelligence

The architecture of conversational AI systems is increasingly shifting from fully cloud-based approaches toward more distributed models:

Personal AI agents that run primarily on user devices, maintaining private knowledge bases about individual preferences and patterns

Hybrid processing systems that handle sensitive functions locally while leveraging cloud resources for compute-intensive tasks

User-controlled cloud instances where individuals own their data and the processing resources that operate on it

Decentralized learning approaches that improve AI systems without centralizing user data

These architectural shifts fundamentally change the privacy equation by keeping more personal data under user control rather than aggregating it in centralized corporate repositories.

Evolving Regulatory Approaches

Privacy regulation for conversational AI continues to develop, with several emerging trends:

AI-specific regulations that address unique challenges beyond general data protection frameworks

Global convergence around core privacy principles despite regional variations in specific requirements

Certification programs providing standardized ways to verify privacy protections

Algorithmic transparency requirements mandating explanation of how AI systems use personal data

These regulatory developments will likely establish clearer boundaries for conversational AI while potentially creating more predictable compliance environments for developers.

Shifting User Expectations

User attitudes toward privacy in conversational contexts are evolving as experience with these technologies grows:

Increasing sophistication about privacy trade-offs and the value of personal data

Greater demand for transparency about how conversational data improves AI systems

Rising expectations for granular control over different types of personal information

Growing concern about emotional and psychological profiles created through conversation analysis

These evolving attitudes will shape market demand for privacy features and potentially reward companies that offer stronger protections.

Ethical AI and Value Alignment

Beyond legal compliance, conversational AI is increasingly evaluated against broader ethical frameworks:

Value alignment ensuring AI systems respect user privacy values even when not legally required

Distributive justice addressing privacy disparities across different user groups

Intergenerational equity considering long-term privacy implications of data collected today

Collective privacy interests recognizing that individual privacy choices affect broader communities

These ethical considerations extend privacy discussions beyond individual rights to consider societal impacts and collective interests that may not be fully addressed by individual choice frameworks.

Privacy as Competitive Advantage

As privacy awareness grows, market dynamics around conversational AI are evolving:

Privacy-focused alternatives gaining traction against data-intensive incumbents

Premium positioning for high-privacy options in various market segments

Increased investment in privacy-enhancing technologies to enable differentiation

Enterprise buyers prioritizing privacy features in procurement decisions

These market forces create economic incentives for privacy innovation beyond regulatory compliance, potentially accelerating development of privacy-respecting alternatives.

The future of privacy in conversational AI will be shaped by the interplay of these technological, regulatory, social, and market forces. While perfect privacy solutions remain elusive, the direction of development suggests increasing options for users who seek more privacy-respecting conversational experiences.

For developers, businesses, and users engaged with these systems, staying informed about emerging approaches and actively participating in shaping privacy norms and expectations will be essential as conversational AI becomes an increasingly central part of our digital lives.

Conclusion: Toward Responsible Conversational AI

As conversational AI continues its rapid evolution and integration into our daily lives, the privacy challenges we've explored take on increasing urgency. These systems promise tremendous benefits—more natural human-computer interaction, accessibility for those who struggle with traditional interfaces, and assistance that adapts to individual needs. Realizing these benefits while protecting fundamental privacy rights requires thoughtful navigation of complex trade-offs.

The path forward isn't about choosing between functionality and privacy as mutually exclusive options. Rather, it involves creative problem-solving to design systems that deliver valuable capabilities while respecting privacy boundaries. This requires technical innovation, thoughtful design, organizational commitment, and appropriate regulation working in concert.

For developers, the challenge lies in creating systems that collect only necessary data, process it with appropriate safeguards, and provide meaningful transparency and control. For businesses, it means recognizing privacy as a core value proposition rather than a compliance burden. For users, it involves becoming more informed about privacy implications and expressing preferences through both settings choices and market decisions.

Perhaps most importantly, advancing privacy-respecting conversational AI requires ongoing dialogue between all stakeholders—technologists, businesses, policymakers, privacy advocates, and users themselves. These conversations need to address not just what's technically possible or legally required, but what kind of relationship we want with the increasingly intelligent systems that mediate our digital experiences.

The decisions we make today about conversational AI privacy will shape not just current products but the trajectory of human-AI interaction for years to come. By approaching these challenges thoughtfully, we can create conversational systems that earn trust through respect for privacy rather than demanding trust despite privacy concerns.

The most successful conversational AI won't be the systems that collect the most data or even those that provide the most functionality, but those that strike a thoughtful balance—delivering valuable assistance while respecting the fundamental human need for privacy and control over personal information. Achieving this balance is not just good ethics; it's the foundation for sustainable, beneficial AI that serves human flourishing.